Dat is een vraag die veel organisaties zichzelf stellen wanneer campagnes klikken opleveren, maar geen rendabele leads of omzet.

In de praktijk zien we dat Google Ads zelden het probleem is, maar dat campagnes optimaliseren op verkeerde doelen, onvolledige data of een structuur die niet aansluit op de funnel.

In dit artikel laten we zien welke 7 oorzaken wij het vaakst tegenkomen wanneer Google Ads niet werkt, hoe je deze problemen herkent in je eigen account, en wat het verschil is tussen iets dat te herstellen is en een setup die opnieuw moet worden opgebouwd.

Wanneer kun je echt zeggen dat Google Ads niet werkt?

Je kunt pas zeggen dat Google Ads niet werkt wanneer campagnes na een realistische testperiode structureel geen bijdrage leveren aan omzet of kwalitatieve leads, terwijl de basis van het Google Ads account goed is ingericht. Dat betekent: het account draait minimaal 8–12 weken, er is voldoende budget om leerdata op te bouwen en optimalisaties zijn consequent doorgevoerd.

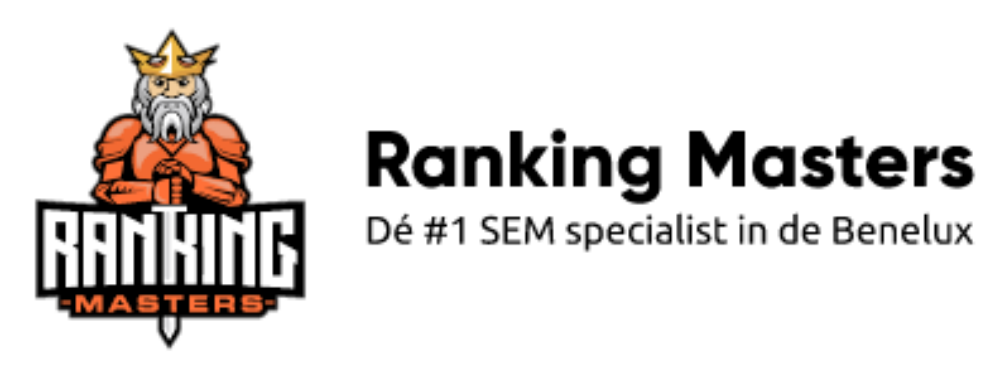

In de praktijk is er sprake van een structureel probleem wanneer:

- Conversies worden gemeten, maar niet leiden tot sales, omzet of opvolgbare leads.

- Kosten per conversie blijven stijgen zonder verbetering in kwaliteit of volume.

- Campagnes, advertentiegroepen en zoekwoorden reageren nauwelijks op aanpassingen in biedstrategie, budget of targeting.

- Slimme campagnes zoals Performance Max zichtbaar opschalen op volume, terwijl rendement uitblijft.

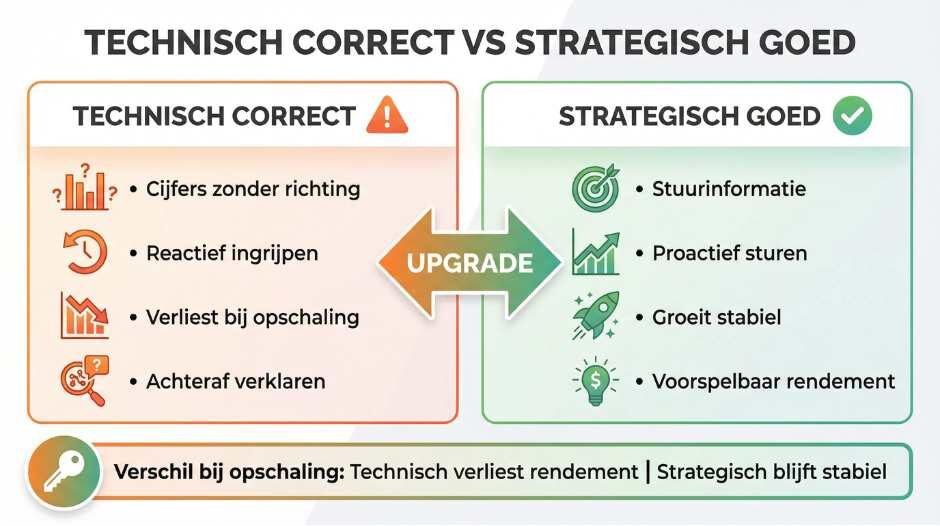

Dit zijn geen tijdelijke schommelingen, maar signalen dat Google Ads optimaliseert op verkeerde input. Het platform functioneert technisch correct, maar stuurt op doelen, data of structuren die niet aansluiten op de commerciële realiteit.

Pas wanneer deze voorwaarden zijn vervuld en resultaten alsnog uitblijven, kun je onderbouwd concluderen dat Google Ads in zijn huidige opzet niet werkt.

Bij het controleren van de status van je campagnes en nieuwe advertenties kun je in het Google Ads account het tabblad ‘Advertenties en extensies’ openen. Hier zie je per advertentie de status, zoals ‘goedgekeurd’, ‘afgekeurd’ of ‘in behandeling’. Wanneer je een melding ontvangt over een foutmelding of afgekeurde advertentie, krijg je vaak ook een e mailadres of link naar tools waarmee je de volgende stappen kunt nemen om je advertenties weer te laten weergeven.

Daarnaast is het belangrijk om te controleren of je zoekwoorden en advertentiegroepen correct zijn ingesteld en geen overlappende targeting bevatten, bijvoorbeeld door vergelijkbare zoekwoorden in meerdere campagnes te gebruiken. Dit kan namelijk voorkomen dat je advertenties optimaal worden weergegeven in het zoeknetwerk.

Door deze verschillende redenen en signalen goed te monitoren en te begrijpen, weet je beter wanneer Google Ads niet werkt en welke acties je kunt ondernemen om je campagnes weer succesvol te maken.

Oorzaak 1: Waarom sturen Google Ads campagnes op de verkeerde conversies?

Google Ads werkt niet wanneer campagnes optimaliseren op conversies die geen directe relatie hebben met omzet of leadkwaliteit. In veel accounts zien we dat micro-acties zoals paginaweergaven, klikken op contactgegevens of generieke formulierinzendingen als primaire conversie zijn ingesteld.

Google Ads optimaliseert hier vervolgens volledig op, waardoor budget verschuift naar verkeer dat wel converteert in het account, maar niet in de business.

Je herkent dit probleem aan een aantal concrete signalen:

- De kosten per conversie zijn laag, maar sales of opvolgbare leads blijven uit.

- Conversies nemen toe, terwijl omzet of leadkwaliteit daalt.

- Performance Max of Smart Bidding schaalt vooral volume, zonder zichtbare verbetering in rendement.

- Sales geeft aan dat leads “niet koopgericht” zijn, terwijl Google Ads positieve cijfers laat zien.

Dit is geen optimalisatieprobleem, maar een meetprobleem. Google Ads leert uitsluitend van de doelen die je meegeeft.

Zijn deze doelen niet gekoppeld aan echte bedrijfswaarde, dan stuurt het systeem consequent de verkeerde kant op. Pas wanneer conversies zijn gedefinieerd op basis van gekwalificeerde acties of omzetwaarden, kan Google Ads daadwerkelijk bijdragen aan winstgevende groei.

Daarnaast is het belangrijk om de advertentietekst en de bijbehorende bestemmingspagina goed op elkaar af te stemmen. Wanneer de advertentie klikt genereert, maar de landingspagina niet overeenkomt met de verwachtingen van de bezoeker, zal dit de conversieratio negatief beïnvloeden en kan Google Ads minder advertenties weergeven vanwege een lage kwaliteitsscore.

Zorg er ook voor dat je de meest recente versie van je advertentie gebruikt en regelmatig de instellingen controleert om te voorkomen dat oude of gewijzigde advertenties de prestaties negatief beïnvloeden.

Tot slot is het aan te raden om negatieve zoekwoorden en woordgroepen te selecteren die niet relevant zijn voor je product of dienst, zodat je advertenties alleen worden geactiveerd door zoekwoorden die daadwerkelijk aansluiten bij de interesses van je doelgroep. Zo voorkom je dat je budget wordt verspild aan irrelevante vertoningen of klikken.

Door deze veelvoorkomende redenen te herkennen en aan te pakken, kun je zorgen dat je Google Ads campagnes effectiever worden en daadwerkelijk bijdragen aan je bedrijfsresultaten.

Bekroonde Agentic Search agency met 16 jaar ervaring

Google Ads voorstel op maat.

- Onderbouwde analyse (10+ uur) met concrete verbeterpunten

- Heldere strategie en roadmap richting de doelstelling

- Begeleiding door een senior specialist met bewezen expertise

Oorzaak 2: Waarom is er te weinig of verkeerde data om goed te optimaliseren?

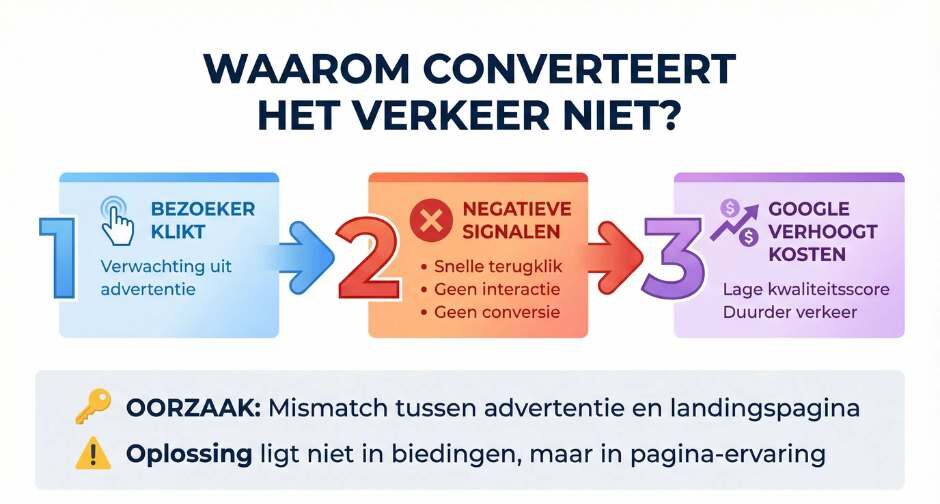

Google Ads werkt niet wanneer het algoritme beslissingen moet nemen op basis van onvoldoende of onbetrouwbare data. Slimme biedstrategieën en Performance Max hebben consistente conversies nodig om patronen te herkennen.

In de praktijk zien we dat campagnes óf te weinig relevante conversies genereren, óf dat conversiedata vervuild is door dubbele metingen, ontbrekende consent-signalen of verkeerd ingestelde events. Het gevolg is dat Google Ads blijft bijsturen zonder stabiele richting.

Je kunt dit probleem concreet herkennen als:

- Campagnes na meerdere weken geen stabiel prestatieniveau bereiken.

- Kleine budgetwijzigingen direct grote prestatiedalingen of pieken veroorzaken.

- Google Ads resultaten structureel afwijken van CRM of back-end omzetcijfers.

- Performance Max budget verdeelt zonder duidelijk verband met rendement.

Als vuistregel geldt dat Google Ads pas betrouwbaar kan optimaliseren bij minimaal 20–30 waardevolle conversies per maand per campagnetype, gemeten op acties die commercieel relevant zijn.

Wordt deze drempel niet gehaald of is de data inconsistent, dan lijkt Google Ads onvoorspelbaar of inefficiënt. In werkelijkheid ontbreekt de datagrondslag die nodig is om het systeem effectief te laten werken.

Oorzaak 3: Waarom sluit de campagnestructuur niet aan op de funnel?

Google Ads werkt niet wanneer campagnes alle fases van de funnel door elkaar heen bedienen, zonder duidelijke rolverdeling. In veel accounts zien we dat Search, Performance Max en soms Display tegelijk worden ingezet om “alles te doen”: verkeer aantrekken, leads genereren én omzet realiseren.

Het gevolg is dat Google Ads geen helder signaal krijgt welke campagnes verantwoordelijk zijn voor welke fase, waardoor budget verschuift naar het makkelijkst te behalen volume in plaats van naar winstgevende conversies.

Je herkent een funnel-mismatch aan deze concrete signalen:

- Campagnes concurreren onderling op dezelfde zoektermen of doelgroepen.

- Performance Max pakt zichtbaar branded en informatieve intentie, terwijl dit niet de bedoeling is.

- Search campagnes leveren verkeer, maar Performance Max claimt de conversies.

- Resultaten zijn moeilijk te verklaren of toe te wijzen aan één kanaal of campagnetype.

- In een effectieve Google Ads-structuur heeft ieder campagnetype een duidelijke taak: Search vangt actieve koopintentie af, Performance Max schaalt bewezen conversies en Display of YouTube ondersteunt bereik en herkenning.

Ontbreekt deze scheiding, dan optimaliseert Google Ads technisch gezien correct, maar op basis van een onduidelijke strategie. Het resultaat is een account dat veel doet, maar weinig gecontroleerd groeit.

Oorzaak 4: Waarom trekken zoekwoorden en targeting de verkeerde bezoekers aan?

Google Ads werkt niet wanneer campagnes structureel bezoekers aantrekken die geen directe koopintentie hebben. Dit gebeurt vaak bij het gebruik van brede matchtypes zonder voldoende uitsluitingszoekwoorden, of bij targeting die te ruim is ingesteld om “volume te maken”.

In de praktijk zien we dat advertenties dan verschijnen op zoekopdrachten die inhoudelijk relevant lijken, maar waarbij de gebruiker nog oriënteert, vergelijkt of informatie zoekt. Dit betekent dat je advertenties wel worden weergegeven, maar niet de juiste doelgroep bereiken.

Je kunt dit probleem concreet herkennen als:

- Het zoektermenrapport voornamelijk bestaat uit informatieve of verkennende zoekopdrachten.

- Campagnes veel klikken genereren, maar een lage conversieratio houden.

- Conversies vooral bestaan uit zachte acties, terwijl sales uitblijft.

- Kosten per conversie blijven stijgen ondanks stabiele CPC’s.

In deze situatie optimaliseert Google Ads richting bereik en klikvolume, omdat er onvoldoende signalen zijn die koopintentie afdwingen.

Zonder duidelijke afbakening van matchtypes, consistente negatieve zoekwoorden en gerichte targeting, verschuift budget automatisch naar verkeer dat makkelijk te verkrijgen is, maar weinig oplevert. Google Ads presteert dan technisch correct, maar niet commercieel effectief.

Om dit te voorkomen, is het belangrijk dat adverteerders de juiste zoekwoorden kiezen en negatieve zoekwoorden gebruiken om irrelevante zoekopdrachten uit te sluiten. Navigeer in je Google Ads account naar het zoekwoordrapport om te zien welke zoektermen je advertenties activeren en verwijder zoekwoorden die niet relevant zijn. Zo voorkom je dat je budget wordt verspild aan klikken die niets opleveren.

Daarnaast is het verstandig om de targeting regelmatig te controleren en aan te passen wanneer deze te ruim is ingesteld. Kies specifieke doelgroepen en segmenten die aansluiten bij je product of dienst, en stel limieten in om te voorkomen dat advertenties worden getoond aan gebruikers zonder koopintentie.

Door deze regels te volgen en feedback uit de zoekresultaten te gebruiken, kun je de kwaliteit van je verkeer verbeteren en zorgen dat je advertenties effectiever worden ingezet. Zorg er ook voor dat je de meest recente versie van je advertenties gebruikt en dat de verbinding tussen je Google Ads account en eventuele analysetools goed functioneert. Dit helpt je om logbestanden en data te monitoren en snel te reageren op wijzigingen in zoekgedrag of advertentieprestaties.

Oorzaak 5: Waarom zetten biedstrategieën en budgetten kosten om in volume in plaats van rendement?

Google Ads werkt niet wanneer biedstrategieën en budgetverdeling sturen op uitgaven en volume, in plaats van op winstgevende resultaten.

Dit zien we vaak bij accounts die (te vroeg) overstappen op slimme biedstrategieën zoals Maximaliseer conversies of Maximaliseer conversiewaarde, zonder dat er duidelijke rendementsdoelen zijn vastgelegd.

Google Ads krijgt dan één impliciet signaal: meer is beter. Het systeem volgt dat signaal consequent, ook als extra volume nauwelijks extra waarde oplevert.

Je herkent dit probleem aan een aantal concrete signalen:

- Budgetten worden volledig uitgegeven, maar omzet of leadkwaliteit groeit niet mee.

- Kosten per conversie of ROAS verslechteren zodra het budget wordt verhoogd.

- Campagnes presteren acceptabel bij lage budgetten, maar breken zodra ze worden opgeschaald.

- Performance Max besteedt steeds meer budget aan kanalen met lage instapdrempels, zoals display of video.

EEAT technisch zien we hier geen “fout” in Google Ads zelf, maar een strategische mismatch tussen doel en inzet. Slimme biedstrategieën werken alleen betrouwbaar wanneer ze duidelijke grenzen krijgen, zoals een target CPA, target ROAS of waardeprioritering.

Ontbreekt die sturing, dan optimaliseert Google Ads rationeel naar maximaal volume binnen het beschikbare budget. Het resultaat voelt als inefficiëntie, terwijl het in werkelijkheid een logisch gevolg is van onvoldoende richting.

Oorzaak 6: Waarom converteert het verkeer niet op de website of landingspagina?

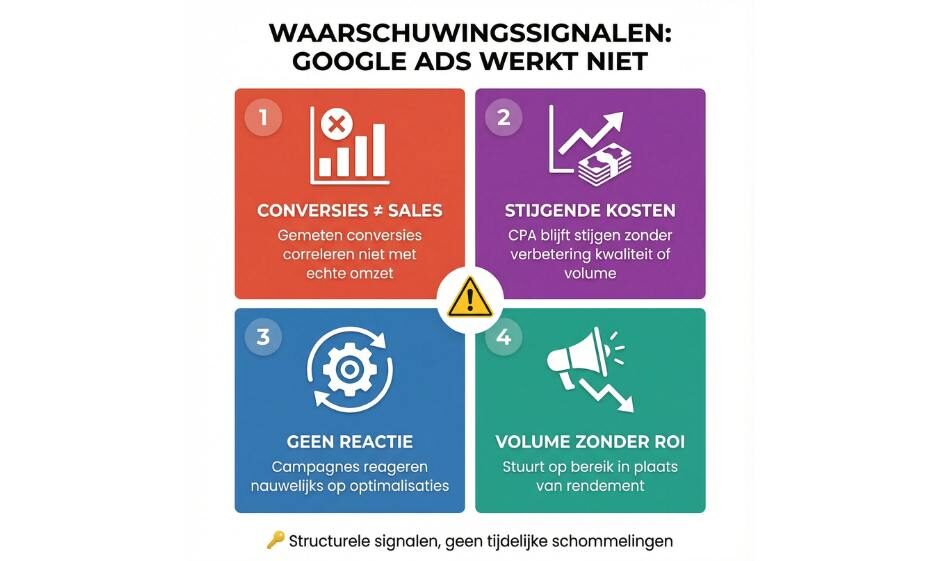

Google Ads werkt niet wanneer het algoritme leert dat bezoekers na de klik niet krijgen wat ze verwachten. Google meet dit via gedragssignalen zoals snelle terugkliks, weinig interactie en uitblijvende conversies.

Wanneer deze signalen structureel negatief zijn, concludeert Google dat de landingspagina onvoldoende relevant is en wordt het verkeer duurder of minder frequent getoond.

De oorzaak ligt meestal in een mismatch tussen advertentie en pagina. De advertentie wekt een duidelijke verwachting, maar de landingspagina is te algemeen, te traag of onduidelijk over de vervolgstap.

Bezoekers haken daardoor af, waarna Google Ads dit interpreteert als lage kwaliteit. Dit effect is ook expliciet benoemd door Google zelf: de landing page experience is een directe factor in advertentieprestaties en kosten.

Zolang de pagina onvoldoende duidelijkheid, vertrouwen of relevantie biedt, kan Google Ads dit niet oplossen met betere biedingen of targeting. In dat geval ligt het probleem niet in het advertentieaccount, maar in de ervaring ná de klik.

Oorzaak 7: Waarom ontbreekt strategische regie en eigenaarschap binnen Google Ads?

Google Ads werkt niet wanneer het kanaal wordt beheerd als los advertentie instrument, in plaats van als onderdeel van een bredere groeistrategie. In veel organisaties zien we dat campagnes technisch worden bijgehouden, maar dat niemand eindverantwoordelijk is voor de vraag waarom budget wordt ingezet, welke rol Google Ads speelt in de totale funnel en welk rendement acceptabel is. Zonder deze regie optimaliseert Google Ads op korte termijnsignalen, terwijl langetermijndoelen uit beeld raken.

Dit herken je aan situaties waarin:

- Campagnes vooral worden beoordeeld op klik of conversiecijfers, niet op omzet of kwaliteit.

- Er regelmatig wordt bijgestuurd zonder duidelijke hypothese of strategisch kader.

- Google Ads losstaat van CRM, salesfeedback of andere marketingkanalen.

- “Meer budget” of “andere biedstrategie” de standaardoplossing is bij tegenvallende resultaten.

Vanuit EEAT perspectief zien we hier dat prestaties niet falen door gebrek aan kennis van het platform, maar door gebrek aan eigenaarschap. Google Ads vraagt om duidelijke keuzes: wat is een rendabele lead, wanneer is opschalen verantwoord en wanneer niet, en hoe verhoudt Ads zich tot SEO, CRO en sales.

Ontbreekt die sturing, dan doet Google Ads exact wat het systeem is gevraagd: optimaliseren binnen onduidelijke kaders. Het resultaat is een account dat actief is, maar niet gericht groeit.

Wat kun je doen als Google Ads nu niet werkt, maar wel potentie heeft?

Wanneer Google Ads geen rendement oplevert, ligt de oplossing zelden in méér optimaliseren. In de meeste gevallen is eerst nodig om vast te stellen waar het systeem wordt beperkt: door onjuiste meting, onvoldoende data, een onduidelijke campagnestructuur, verkeerde instroom of een landingspagina die niet overtuigt. Zolang die oorzaak niet scherp is, versterkt verdere optimalisatie vooral bestaande inefficiëntie.

Een effectieve aanpak begint met het herstellen van de randvoorwaarden. Dat betekent sturen op conversies die direct gekoppeld zijn aan omzet of leadkwaliteit, controleren of data betrouwbaar is en expliciet vastleggen welke rol Google Ads vervult binnen de totale funnel. Pas wanneer deze basis klopt, krijgen biedstrategieën en budgetverdeling daadwerkelijk betekenis.

Organisaties die dit goed aanpakken, beoordelen Google Ads niet op losse metrics, maar in samenhang met salesdata en marge. Werkt Google Ads dan nog steeds niet, dan is dat geen gevoel of aanname, maar een onderbouwde conclusie. In dat geval is herinrichting of heroverweging van het kanaal rationeler dan blijven bijsturen op symptomen.

Hoe bepaal je of optimaliseren zinvol is of dat een herbouw nodig is?

Je bepaalt dit door te toetsen of Google Ads voorspelbaar reageert op gerichte aanpassingen. Een account is geschikt om te optimaliseren wanneer wijzigingen in doelen, biedstrategieën of budgetten binnen enkele weken leiden tot logisch verklaarbare veranderingen in prestaties.

Zie je bijvoorbeeld dat kosten per conversie verbeteren zodra je targets aanscherpt, of dat volume gecontroleerd meegroeit bij budgetverhoging, dan werkt het onderliggende systeem.

Een herbouw is nodig wanneer dit effect uitblijft. Dat herken je aan situaties waarin aanpassingen nauwelijks invloed hebben, resultaten wisselvallig blijven of verbeteringen alleen tijdelijk optreden. In de praktijk betekent dit vaak dat historische data, foutieve conversies of een onduidelijke campagnestructuur het algoritme blijven sturen. Je optimaliseert dan niet, maar corrigeert symptoombestrijding.

Je kunt dit concreet toetsen met drie vragen:

- Veranderen prestaties aantoonbaar nadat je doelen of targets aanpast?

- Is er een logisch verband tussen budgetwijzigingen en resultaat?

- Kun je prestaties verklaren zonder terug te vallen op aannames?

Kun je deze vragen niet met data beantwoorden, dan is optimaliseren zinloos. In dat geval is een herbouw de enige manier om Google Ads opnieuw leerbaar te maken. Dat maakt deze keuze niet complex, maar meetbaar en rationeel.

Hoe bepaal je of optimaliseren zinvol is of dat een herbouw nodig is?

Je bepaalt dit door te toetsen of Google Ads voorspelbaar reageert op gerichte aanpassingen. Een account is geschikt om te optimaliseren wanneer wijzigingen in doelen, biedstrategieën of budgetten binnen enkele weken leiden tot logisch verklaarbare veranderingen in prestaties.

Zie je bijvoorbeeld dat kosten per conversie verbeteren zodra je targets aanscherpt, of dat volume gecontroleerd meegroeit bij budgetverhoging, dan werkt het onderliggende systeem.

Een herbouw is nodig wanneer dit effect uitblijft. Dat herken je aan situaties waarin aanpassingen nauwelijks invloed hebben, resultaten wisselvallig blijven of verbeteringen alleen tijdelijk optreden.

In de praktijk betekent dit vaak dat historische data, foutieve conversies of een onduidelijke campagnestructuur het algoritme blijven sturen. Je optimaliseert dan niet, maar corrigeert symptoombestrijding.

Je kunt dit concreet toetsen met drie vragen:

- Veranderen prestaties aantoonbaar nadat je doelen of targets aanpast?

- Is er een logisch verband tussen budgetwijzigingen en resultaat?

- Kun je prestaties verklaren zonder terug te vallen op aannames?

Kun je deze vragen niet met data beantwoorden, dan is optimaliseren zinloos. In dat geval is een herbouw de enige manier om Google Ads opnieuw leerbaar te maken. Dat maakt deze keuze niet complex, maar meetbaar en rationeel.

Bekroonde Agentic Search agency met 16 jaar ervaring

Google Ads voorstel op maat.

- Onderbouwde analyse (10+ uur) met concrete verbeterpunten

- Heldere strategie en roadmap richting de doelstelling

- Begeleiding door een senior specialist met bewezen expertise

Wat is de belangrijkste conclusie als Google Ads niet werkt?

Wanneer Google Ads niet het gewenste resultaat oplevert, ligt de oorzaak zelden bij het platform zelf. In vrijwel alle gevallen zien we dat prestaties worden beperkt door keuzes in meting, data, structuur, instroom, landingspagina’s of strategische aansturing.

Google Ads werkt exact volgens de signalen die het krijgt. Als die signalen niet zijn gekoppeld aan echte bedrijfswaarde, stuurt het systeem logisch, maar niet rendabel.

De kern is daarom niet harder optimaliseren, maar eerst scherp krijgen waar het systeem op reageert en waarom. Pas wanneer conversies betekenisvol zijn, data betrouwbaar is en de rol van Google Ads binnen de funnel duidelijk is, kun je eerlijk beoordelen of het kanaal bijdraagt aan groei.

Werkt Google Ads dan nog steeds niet, dan is dat geen aanname meer, maar een onderbouwde conclusie op basis van gedrag en data.

Er zijn twee manieren waarop je je website mobile friendly kunt maken.

Er zijn twee manieren waarop je je website mobile friendly kunt maken.

Alle trends die hier genoemd zijn draaien maar om één ding: de gebruiker. Google wil haar klanten de beste websites aanbieden die snel laden, werken op het apparaat dat ze gebruiken, gestructureerde en duidelijke teksten aanbieden en spreekopdrachten beantwoorden. Het liefste geeft Google zelfs een website die al antwoord geeft op de vraag voordat deze geopend wordt (featured snippets).

Alle trends die hier genoemd zijn draaien maar om één ding: de gebruiker. Google wil haar klanten de beste websites aanbieden die snel laden, werken op het apparaat dat ze gebruiken, gestructureerde en duidelijke teksten aanbieden en spreekopdrachten beantwoorden. Het liefste geeft Google zelfs een website die al antwoord geeft op de vraag voordat deze geopend wordt (featured snippets).