Crawlen is het proces waarbij zoekmachines jouw website doorzoeken met zogenaamde webcrawlers (ook wel spiders of bots genoemd). Deze crawlers “kruipen” van link naar link, die aan elkaar gekoppeld zijn via hyperlinks, en verzamelen informatie over de pagina’s die ze tegenkomen. Die informatie wordt vervolgens doorgestuurd naar de servers van de zoekmachine.

Stel je crawlen voor als een digitale bibliothecaris die langs alle boekenplanken loopt, notities maakt over de inhoud en opschrijft waar elk boek te vinden is. Zonder die inventarisatie kan niemand de juiste boeken vinden. Zo werkt het ook online: zonder crawlen kan Google jouw pagina’s niet opnemen in de zoekindex.

Belangrijk om te weten: crawlen is niet hetzelfde als indexeren. Crawlen is het ontdekken en analyseren van pagina’s, indexeren is het daadwerkelijk opslaan in de zoekmachine database zodat de pagina kan worden weergegeven en ranken.

👉 Concreet: crawlen = vinden en scannen, indexeren = opslaan en tonen.

Key Takeaways

- Zonder crawlen geen zichtbaarheid – als Google je pagina’s niet kan crawlen, worden ze ook niet geïndexeerd en dus niet gevonden.

- Crawlbudget is kostbaar – zorg dat Google zijn tijd besteedt aan je belangrijkste pagina’s, niet aan duplicaten of irrelevante URL’s.

- Optimaliseren is vaak praktisch – een goede sitemap, interne links, snelle laadtijd en slim gebruik van robots.txt maken je site direct beter crawlbaar.

- Crawlen is het fundament van SEO – pas wanneer crawlen op orde is, kunnen content en autoriteit hun volle effect hebben en profiteer je maximaal van SEO én AI-gedreven zoekresultaten.

Hoe werkt crawlen precies?

Zoekmachines werken met webcrawlers (ook wel spiders of bots genoemd), stukjes code die het internet continu afspeuren. Ze beginnen bij bekende websites en volgen de koppelingen die aan elkaar gekoppeld zijn via hyperlinks. Zo ontdekken ze steeds nieuwe webpagina’s. Iedere keer dat een crawler een pagina bezoekt, neemt hij informatie mee terug naar de zoekmachine: de inhoud, de structuur, de gebruikte zoekwoorden, metadata en de links naar andere pagina’s.

Het proces stap voor stap

- Ontdekken – De crawler vindt een nieuwe of bestaande URL via een link of je sitemap.

- Bezoeken – De pagina wordt geladen. Hierbij kijkt de bot naar de tekst, afbeeldingen, code, metadata en links.

- Terugkoppelen – De informatie wordt opgeslagen in de servers van de zoekmachine, die later beslissen of en hoe de pagina wordt geïndexeerd.

🔑 Belangrijk verschil:

- Crawlen = ontdekken en lezen, het proces waarbij zoekmachines jouw website doorzoeken en pagina’s opslaat.

- Indexeren = opnemen in de zoekindex zodat de pagina kan ranken.

Een pagina kan dus wel gecrawld zijn maar toch niet zichtbaar worden in Google, bijvoorbeeld door duplicate content, lage kwaliteit of verkeerde pagina’s.

Wat crawlers wel en niet zien

- Openbare pagina’s – Alle pagina’s die zonder drempel bereikbaar zijn.

- Achter login of betaalmuur – Deze zijn voor crawlers onzichtbaar.

- Geblokkeerde pagina’s – Via een robots.txt-bestand of noindex-tag kun je zelf bepalen welke pagina’s crawlers wél of niet mogen bekijken. Dit is handig voor irrelevante of dubbele pagina’s (bijv. filter-URL’s in een webshop).

Rol van interne links

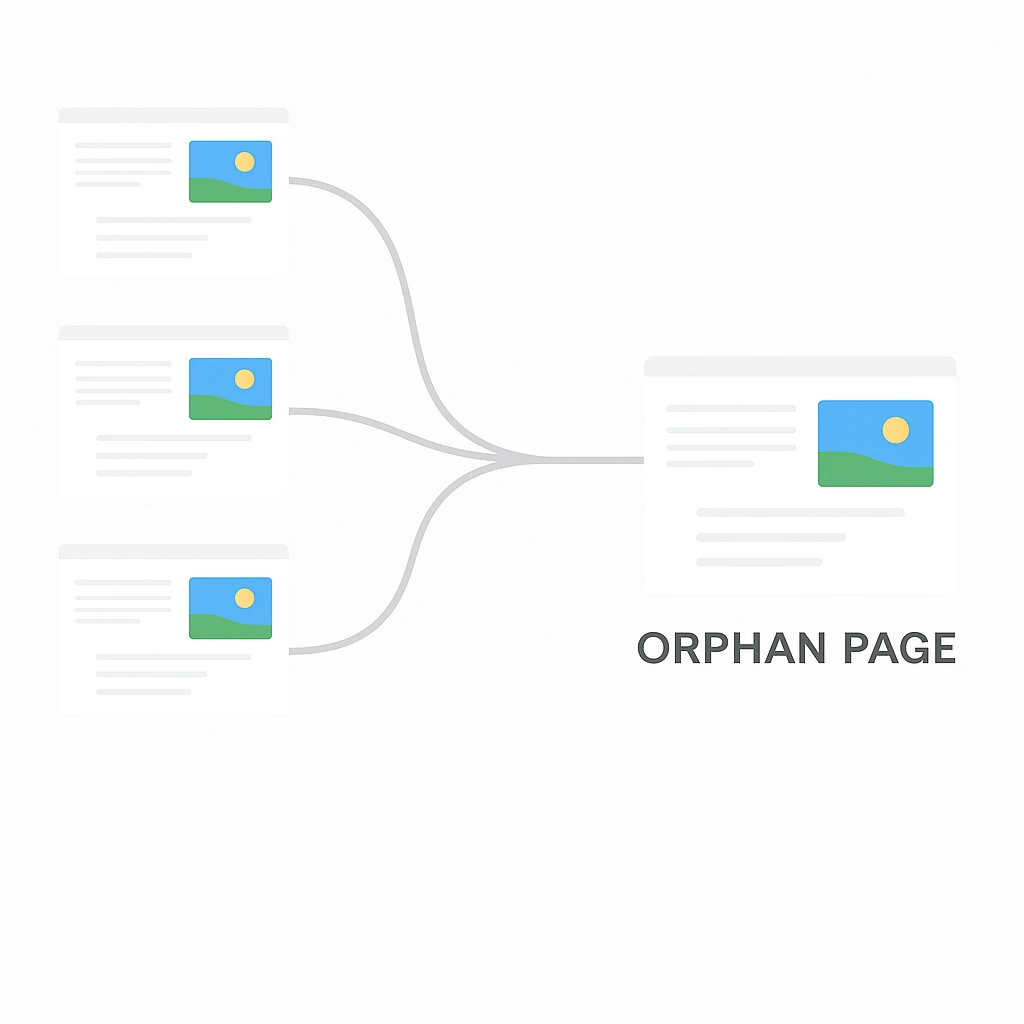

Interne links zijn cruciaal. Zoekmachines bepalen welke pagina’s belangrijk zijn door de interne linkstructuur te volgen. Google volgt links om nieuwe pagina’s te ontdekken. Staat er nergens op je site een link naar een pagina? Dan noemen we dat een orphan page – en de kans is groot dat die pagina nooit of nauwelijks gecrawld wordt.

👉 Praktische tip:

Controleer regelmatig of al je belangrijke pagina’s intern gelinkt zijn, bijvoorbeeld via de hoofdnavigatie, een categoriepagina of interne verwijzingen in je blogs. Een goede interne linkstructuur zorgt ervoor dat crawlers efficiënt kunnen navigeren en helpt bij een betere ranking en zichtbaarheid van je website.

Bekroonde SEO & AI Search agency met 16 jaar ervaring

Technische SEO analyse laten doen.

- Unieke aanpak: onze eigen bewezen SEO werkwijze met een senior-only team

- Volledige grip: direct inzicht in waar je SEO waarde verliest

- Geen standaard audit: maar een grondige, op maat gemaakte SEO analyse

Wat is crawlbudget en waarom is het belangrijk?

Je kunt Google zien als een bezoeker met beperkte tijd. Hij komt langs, kijkt rond en beslist hoeveel pagina’s hij gaat bekijken. Dat aantal noemen we in SEO het crawlbudget. Dit crawlbudget bepaalt de frequentie en het aantal pagina’s dat Google op je website bezoekt en analyseert. Hoe efficiënter jouw website is ingericht, hoe meer waardevolle pagina’s Google kan meenemen – en hoe groter de kans dat je zichtbaar wordt in de zoekresultaten.

Hoe werkt crawlbudget in de praktijk?

Google bepaalt niet vooraf een vast getal, maar kijkt dynamisch naar je site. Is je server snel en stabiel? Dan kan de crawler zonder problemen veel pagina’s doornemen. Heeft je site veel autoriteit en een sterke interne linkstructuur? Dan krijgt hij vaker aandacht en wordt je site vaker gecrawld. Andersom geldt ook: als je website traag laadt, veel duplicate content bevat of gebroken links heeft, dan verspilt Google liever geen tijd en beperkt hij het aantal pagina’s dat hij bekijkt.

Wanneer is crawlbudget echt belangrijk?

Voor kleine websites met een paar tiental pagina’s is crawlbudget meestal geen groot issue: Google kan die makkelijk in één sessie verwerken. Maar voor grote webshops of nieuwssites met duizenden pagina’s is het cruciaal. Als crawlers steeds verstrikt raken in filterpagina’s, redirectketens of verouderde content, blijven je belangrijkste pagina’s buiten beeld en verlies je waardevolle linkwaarde.

Hoe voorkom je dat Google zijn crawlbudget verspilt?

- Houd je sitemap schoon: zet er alleen pagina’s in die je ook echt in Google wilt laten indexeren.

- Gebruik robots.txt slim: sluit irrelevante of eindeloze URL’s uit, zoals zoekfilters of testomgevingen, door duidelijke richtlijnen en instructies in het bestand op te nemen.

- Verzorg je interne links: een heldere structuur met goede navigatie helpt Google sneller bij de juiste content te komen en zorgt dat belangrijke pagina’s goed gekoppeld zijn via hyperlinks.

- Ruim oude rommel op: verwijder of redirect pagina’s die geen waarde meer toevoegen of die een gebroken link vormen.

👉 Tip: kijk in Google Search Console bij Crawlstatistieken. Daar zie je hoeveel pagina’s Google maandelijks bezoekt, de crawl frequentie, en of er foutmeldingen zijn. Zo zie je direct of je crawlbudget goed wordt benut of juist verloren gaat aan pagina’s die er niet toe doen.

Veelvoorkomende crawlproblemen (en hoe je ze oplost)

Crawlproblemen zijn vaak onzichtbaar voor bezoekers, maar ze kunnen je SEO-prestaties flink ondermijnen. Een crawler die vastloopt of zijn tijd verspilt, mist misschien net die belangrijke pagina’s waar jij op gevonden wilt worden. Hieronder vind je de meest voorkomende problemen én hoe je ze zelf kunt oplossen om je crawlbudget optimaal te benutten.

1. Gebroken links en 404-pagina’s

Het probleem: Gebroken links leiden naar een niet-bestaande pagina. Gebruikers zien een foutmelding (404), en crawlers verspillen hun budget op irrelevante URL’s. Te veel 404’s geven Google het signaal dat je website slecht onderhouden wordt, wat je ranking kan schaden en belangrijke linkwaarde doet verliezen.

Zo los je het op:

- Gebruik Google Search Console om alle foutmeldingen te vinden.

- Redirect oude of verplaatste pagina’s met een 301-redirect naar de juiste nieuwe pagina.

- Maak een gebruiksvriendelijke custom 404-pagina die bezoekers doorstuurt naar je hoofdcategorieën of zoekfunctie.

2. Redirectketens en loops

Het probleem: Stel, je oude productpagina verwijst naar een nieuwe, maar die verwijst weer door naar een derde. Voor gebruikers merk je er vaak weinig van, maar crawlers verliezen tijd en autoriteit onderweg, wat je crawlbudget onnodig belast.

Zo los je het op:

- Houd redirects zo kort mogelijk: van A direct naar B.

- Controleer periodiek met tools zoals Screaming Frog of er ketens of loops zijn ontstaan na website-updates.

3. Duplicate content

Het probleem: Wanneer dezelfde inhoud via meerdere URL’s bereikbaar is (bijvoorbeeld door filteropties in een webshop), ziet Google dubbele pagina’s. Het gevolg: versnipperd crawlbudget en lagere rankings.

Zo los je het op:

- Gebruik canonical-tags om de hoofdpagina aan te wijzen.

- Sluit irrelevante varianten uit via robots.txt of een noindex-tag.

- Kijk kritisch: kun je pagina’s samenvoegen en zo sterker maken?

4. Orphan pages (pagina’s zonder links)

Het probleem: Als een pagina nergens intern gelinkt is, kan Google die nauwelijks vinden. Je kunt er een prachtige landingspagina voor SEO van maken, maar zonder links blijft hij onzichtbaar.

Zo los je het op:

- Zorg dat elke waardevolle pagina minimaal één interne link krijgt.

- Verwerk interne links logisch in je navigatie, categoriepagina’s of blogs.

- Controleer orphan pages met een crawler-tool en voeg ze toe aan je structuur.

5. Trage of instabiele websites

Het probleem: Crawlers besteden liever tijd aan snelle, stabiele sites. Als je pagina’s traag laden of servers vaak overbelast raken, beperkt Google zijn bezoeken. Dat betekent dat minder pagina’s zichtbaar worden in de zoekresultaten en je website minder vaak wordt gecrawld.

Zo los je het op:

- Optimaliseer je Core Web Vitals (LCP, INP en CLS).

- Comprimeer afbeeldingen en laad zware scripts pas als dat nodig is.

- Kies voor betrouwbare hosting en gebruik caching of een CDN.

👉 Praktische tip: Plan ieder kwartaal een crawl-audit. Zo ontdek je vroegtijdig of Google tijd verspilt op onbelangrijke URL’s of juist cruciale pagina’s overslaat. Met een tool als Google Search Console kun je hier gratis al veel inzichten uit halen en je website goed laten crawlen en indexeren.

Hoe verbeter je de crawlbaarheid van je website?

Crawlbaarheid verbeteren betekent dat je het zoekmachines zo makkelijk mogelijk maakt om jouw site te ontdekken en te begrijpen. Zie het als het aanleggen van duidelijke wegwijzers en het opruimen van obstakels, zodat Google moeiteloos bij je belangrijkste pagina’s komt.

1. Zorg voor een duidelijke sitestructuur

Een heldere hiërarchie helpt zowel bezoekers als crawlers.

- Zet belangrijke pagina’s zo dicht mogelijk bij de homepage.

- Gebruik categorieën en subcategorieën om orde te scheppen.

- Maak interne links logisch: van gerelateerde blogs naar productpagina’s, van categorieën naar detailpagina’s.

- Zorg dat pagina’s goed aan elkaar gekoppeld zijn via hyperlinks, zodat crawlers eenvoudig van de ene naar de andere pagina kunnen navigeren.

👉 Tip: gebruik breadcrumbs. Ze helpen gebruikers navigeren én geven Google extra context.

2. Dien een schone XML-sitemap in

Een sitemap is de plattegrond die je aan Google meegeeft.

- Zorg dat alleen waardevolle en relevante pagina’s in je sitemap staan.

- Update je sitemap automatisch als er nieuwe pagina’s bijkomen.

- Dien hem in via Google Search Console om zeker te weten dat Google hem gebruikt.

3. Gebruik robots.txt en meta-tags slim

Soms wil je niet dat Google alles crawlt (bijvoorbeeld filterpagina’s of interne zoekresultaten).

- Gebruik robots.txt om crawlers de toegang te ontzeggen tot onbelangrijke secties.

- Voeg een noindex-tag toe aan pagina’s die niet in de zoekresultaten hoeven.

- Let op: blokkeer nooit per ongeluk bepaalde pagina’s die juist wel belangrijk zijn.

4. Verbeter de snelheid en stabiliteit van je site

Een snelle site betekent dat Google meer pagina’s kan crawlen binnen dezelfde tijd.

- Optimaliseer afbeeldingen (gebruik moderne formaten zoals WebP of AVIF).

- Verminder zware scripts en laad ze pas als ze echt nodig zijn.

- Gebruik caching en, waar mogelijk, een CDN.

- Check je Core Web Vitals: streef naar LCP < 2,5s, INP < 200ms, CLS < 0,1.

5. Los duplicate content op

Dubbele pagina’s verspillen crawlbudget.

- Gebruik canonical-tags om de juiste versie aan te wijzen.

- Vermijd eindeloze URL-varianten (bijv. door filters of UTM-tags).

- Voeg waarde samen: liever één sterke pagina dan drie zwakke duplicaten.

6. Zorg dat alle waardevolle pagina’s intern gelinkt zijn

Crawlers ontdekken nieuwe content vooral via links.

- Controleer orphan pages (pagina’s zonder interne links).

- Voeg interne links toe vanuit relevante blogs, categoriepagina’s of de homepage.

- Houd het natuurlijk: link waar het logisch is voor de gebruiker.

7. Houd rekening met mobile first indexing

Google indexeert tegenwoordig vooral de mobiele versie van je website. Zorg daarom dat de mobiele versie van je site volledig toegankelijk is voor crawlers en dezelfde content bevat als de desktopversie.

👉 Praktische stap: begin met een crawl van je eigen site (bijvoorbeeld met Screaming Frog of Ahrefs Site Audit). Je ziet direct welke pagina’s niet goed gelinkt zijn, welke traag zijn en waar fouten zitten. Werk stap voor stap de lijst af, en je crawlbaarheid verbetert vaak al binnen enkele weken.

Tools om crawlen te monitoren

Om je crawlbaarheid te verbeteren, moet je eerst weten hoe zoekmachines je site nu zien. Daarvoor heb je gelukkig een aantal handige hulpmiddelen. Met deze tools ontdek je waar Google vastloopt, of je crawlbudget efficiënt wordt benut, en of je verbeteringen effect hebben.

Google Search Console

De basis en gratis voor iedereen. Hier zie je of pagina’s goed zijn geïndexeerd, waar fouten optreden en hoe vaak Google je site bezoekt. Kijk vooral bij Crawlstatistieken en Indexdekking: dat geeft meteen inzicht of Google de juiste pagina’s meeneemt of juist zijn tijd verspilt aan verkeerde pagina’s. Ook kun je hier zien welke pagina’s niet gecrawld worden en welke pagina’s zijn uitgesloten via robots of noindex-tags.

Screaming Frog of Sitebulb

Dit zijn crawling-tools die je website scannen alsof ze zelf een zoekmachine zijn. Ze halen meteen gebroken links, duplicate content en redirectketens naar boven. Handig is de visuele weergave van je interne linkstructuur: die laat zien of belangrijke pagina’s niet te diep in je site verstopt zitten en hoe pagina’s aan elkaar gekoppeld zijn via hyperlinks.

Logfile-analyse

Wil je echt zeker weten waar Google zijn tijd aan besteedt? Dan is logfile-analyse de beste optie. Daarmee zie je exact welke pagina’s Googlebot heeft bezocht en hoe vaak. Zo ontdek je of je crawlbudget verloren gaat aan irrelevante filter-URL’s in plaats van aan je product- of dienstpagina’s.

PageSpeed Insights & Lighthouse

Snelheid telt dubbel: gebruikers haken af bij trage sites én Google crawlt minder pagina’s als je server traag reageert. Met PageSpeed Insights en Lighthouse meet je hoe snel pagina’s laden en krijg je concrete tips om je Core Web Vitals te verbeteren. Test niet alleen je homepage, maar ook dieperliggende pagina’s zoals blogs of productdetailpagina’s.

Premium SEO-tools (Ahrefs, Semrush, Majestic)

Voor grotere sites of wie de diepte in wil: deze platforms combineren backlink-analyse met technische site-audits. Handig om je crawlbaarheid en gezondheid te vergelijken met die van concurrenten. Ze geven ook inzicht in de indexering van pagina’s en helpen je om je interne linkstructuur en sitemap te optimaliseren.

Gebruik deze tools om het proces van crawlen en indexeren beter te begrijpen en te sturen. Zo zorg je dat je website vaker en efficiënter wordt gecrawld, waardoor je zichtbaarheid in de zoekresultaten verbetert.

👉 Waar te beginnen? Start altijd met Google Search Console en een crawler zoals Screaming Frog. Daarmee krijg je al 80% van de inzichten. Voor grotere of complexere sites kun je uitbreiden met logfile-analyse en premium tools.

Bekroonde SEO & AI Search agency met 16 jaar ervaring

Technische SEO analyse laten doen.

- Unieke aanpak: onze eigen bewezen SEO werkwijze met een senior-only team

- Volledige grip: direct inzicht in waar je SEO waarde verliest

- Geen standaard audit: maar een grondige, op maat gemaakte SEO analyse

Crawlen & SEO-strategie anno 2025

Crawlen is geen doel op zich, maar de essentiële eerste stap in een bredere SEO-strategie waarin ook content, autoriteit en technische optimalisatie centraal staan. Denk aan het SEO-cornermodel: als de techniek niet klopt, kunnen content en linkbuilding simpelweg niet hun volle effect hebben.

Crawlen als fundament voor succes

Zonder een goede crawlbaarheid kan Google je content niet vinden. En wat niet gevonden wordt, kan ook niet ranken in de zoekresultaten. Daarom is crawlen de fundering van je SEO-aanpak: een stevige basis zorgt ervoor dat je kunt bouwen aan sterke content en een betrouwbare autoriteit. Het proces waarbij zoekmachines jouw website crawlen, waarbij de crawler de koppelingen volgt en pagina’s opslaat, is cruciaal om je zichtbaarheid te vergroten.

Sneller indexeren, sneller resultaat

Hoe beter je website te crawlen is, hoe sneller Google nieuwe pagina’s oppikt en in de index opneemt. Voor bedrijven die regelmatig nieuwe producten, blogs of updates publiceren, kan dit het verschil betekenen tussen snel zichtbaar zijn of pas weken later in de zoekresultaten verschijnen.

👉 Voorbeeld: lanceer je een nieuwe productcategorie? Als je sitemap up-to-date is, de interne linkstructuur logisch en goed onderhouden is, en je pagina’s snel laden, wordt je content vaak binnen een dag of zelfs enkele uren gecrawld en geïndexeerd. Zo blijft je website langer Google’s aandacht houden en voorkom je dat je pagina’s onnodig lang wachten.

Crawlen in het AI-tijdperk

Met de opkomst van AI Overviews en geavanceerde tools zoals ChatGPT is crawlbaarheid belangrijker dan ooit. AI-systemen halen hun informatie uit bestaande websites. Als jouw content lastig te crawlen is, wordt het ook minder vaak gebruikt als betrouwbare bron voor AI-antwoorden.

Door gebruik te maken van gestructureerde data, duidelijke koppen en een logische interne linkstructuur die pagina’s aan elkaar koppelt via hyperlinks, zorg je ervoor dat zowel zoekmachines als AI-modellen je content beter begrijpen en vaker opnemen in hun index. Het toepassen van de juiste termen en metadata helpt bij het duidelijk maken waar je artikel over gaat, waardoor je beter gevonden wordt op relevante zoektermen.

De strategie in één zin

Technische SEO (crawlen), sterke content en autoriteit versterken elkaar. Zorg dat Google moeiteloos bij je content kan komen en dat je website goed is ingericht om gecrawld te worden, dan haal je méér rendement uit alles wat je schrijft en publiceert.